OpenAIが最新鋭のAIモデルを発表した。その名はOpenAI o3(オースリー)。前モデルo1と比較にならないほどの大きな進化なのでo3と名付けたのだという。ベンチマークと呼ばれる評価テストで博士号取得者を超える知能レベルに達したというが、果たしてo3は人間の知能を超えたのだろうか。

OpenAIの発表によるとo3は次のようなベンチマークや試験で高得点を得たという。

•世界レベルのプログラミング能力:

–ソフトウェアの難題を、以前のモデルより20%以上も高い精度で解決

–世界的なプログラミングコンテストで、トップレベルの競技プログラマーに匹敵する実力

•数学オリンピックレベルの数学力:

–AIME(アメリカ招待数学試験)で、驚異の96.7%正答率を達成

–アメリカの数学オリンピック代表選考にも使われる超難関試験をほぼ完璧に解きこなす、圧倒的な数学的思考力

•専門数学者も苦戦する超難問を解く:

–「Epic AI Frontier Math」は、専門家でも解くのに数日かかる超難問を含む、極めて難しいベンチマーク

–人間の正答率は非常に低いと推測される中、O3は25%以上の正答率を達成

•博士研究者レベルの科学的思考力:

–GPQ-Diamondという、博士レベルの科学者が苦戦する難題でも、87.7%という驚異的な正答率を達成。

–専門分野を持つ博士研究者でさえ、70%程度の正答率

–o3の科学的な理解力は人間を超えている可能性

確かに数学、科学、プログラミングなどの領域で、トップレベルの研究者と同等もしくはそれ以上の成績を収めたようだ。しかしだからと言って人間の能力を超えたことになるのだろうか。

人間の知能を超えた人工知能という意味で使われる言葉にAGI(汎用人工知能、Artificial General Intelligence)というものがある。AGIの定義は実はいくつも存在するが、OpenAIは「経済的に価値のあるほとんどの仕事で人間を超える自律的システム」と定義している。人間に代わって多くの仕事を代替できるのかどうかを重視しているわけだ。

こうしたベンチマークで人間を超えたからと言ってAGIではないと主張する人たちがいる。多彩な自動化ツールを提供する米ZapierのMike Knoop氏もその一人だ。人間は新しい仕事でも説明を受ければすぐにできるようになる。ところがAIは、新しいスキルを学ぶのに大量のデータと計算資源が必要になる。いい大学を出たけれど仕事を覚えるのが非常に遅い新入社員のようなものだ。人間並みに仕事を覚えられないのであれば、人間に代わって多くの仕事を代替するなんて不可能だ。

そこでKnoop氏らは、人間並みに新しい仕事を学べるかどうかを計測する新しいベンチマーク「ARC-AGI-PUB」の利用を提唱している。

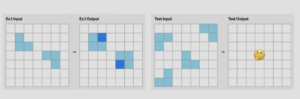

例えばそのベンチマークの中には次のような質問がある。

https://www.youtube.com/live/SKBG1sqdyIU?si=vKNeVWBDmiGaE6Nb

左から1枚目がインプット、2枚目がアウトプットの例。3枚目のインプットに対してどんなアウトプットになるのか、というのが問いだ。恐らく3枚の薄い青色のブロックの穴部分を濃い青のブロックで埋める、というようなパターンになっているのだろう。

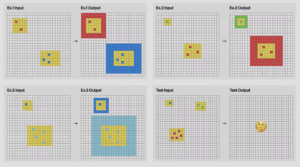

では次の質問はどうだろう。

https://www.youtube.com/live/SKBG1sqdyIU?si=vKNeVWBDmiGaE6Nb

これは黄色の四角の中に赤のブロックが2つあれば黄色の四角の周りに2つの厚さの赤ブロックで囲い、青いブロックが3つあるので3重の青ブロックの厚さで囲う、というパターンを見つけるのが答えなのだろう。

これらの質問に答えることができれば、非常に少ない例から、このタスクでは何を求められているのかを学ぶことができている、ということになる。新しい仕事でも覚えることができる能力に繋がるかもしれない。 このベンチマークの試験を受けた人間の中での最高得点は84点。これまでいろいろなAIモデルがこのベンチマークに挑戦しているが、今年10月の時点では42点が最高得点だった。

ところがo3は87.5点をゲット。人間を超えてきた。

このベンチマークで人間を超えない限りAGIではないと主張していた人たちのベンチマークをo3が超えたわけだ。

ただARC-AGI-PUBの主催者は、この結果を大絶賛しているものの、「実際のところ、o3 はまだ AGI ではないと思います。o3 はまだいくつかの非常に簡単なタスクに失敗しており、人間の知能との根本的な違いを示しています」と語っている。

OpenAIのSam Altman氏もo3がAGIだとはまだ宣言していない。 ただAGIに限りなく近づいたことだけは間違いなさそうだ。

湯川鶴章

AI新聞編集長

AI新聞編集長。米カリフォルニア州立大学サンフランシスコ校経済学部卒業。サンフランシスコの地元紙記者を経て、時事通信社米国法人に入社。シリコンバレーの黎明期から米国のハイテク産業を中心に取材を続ける。通算20年間の米国生活を終え2000年5月に帰国。時事通信編集委員を経て2010年独立。2017年12月から現職。主な著書に『人工知能、ロボット、人の心。』(2015年)、『次世代マーケティングプラットフォーム』(2007年)、『ネットは新聞を殺すのか』(2003年)などがある。趣味はヨガと瞑想。妻が美人なのが自慢。