TechCrunchによると、MITのチームが頭の中の言葉を読み取るマシンを開発したという。しかも精度は92%。脳波ではなさそう。いったいどんな仕組みなんだろう。

TechCrunchの記事は次のように書かれているだけ。

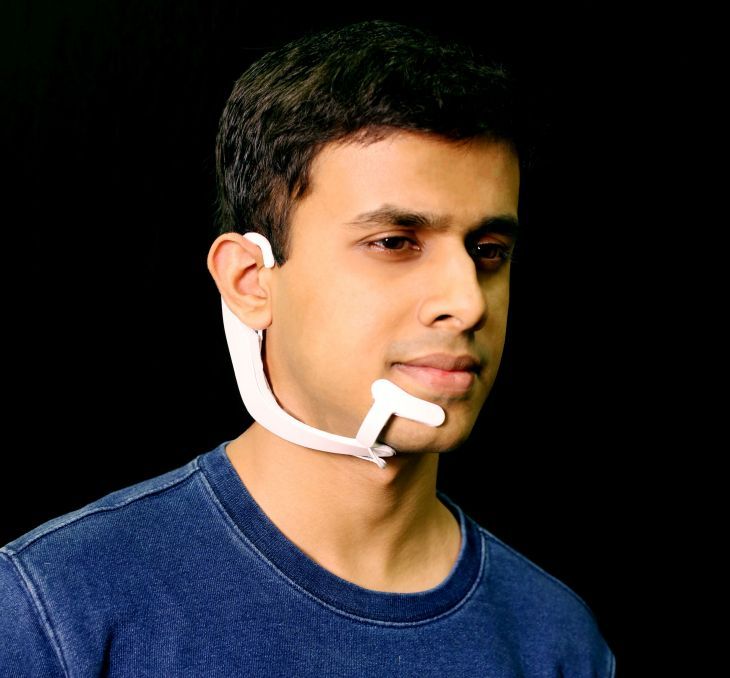

そのAlterEgoと名付けられたデバイスは、頭に、というより顎(あご)に装着する。そしてその電極が、神経筋の信号を読む。それにより、“頭の中の言葉”を読める、という。

もう少し詳しくしりたいので、MITの記事を探して読んでみた。

どうやら発声しようと思っただけで人間の顔の筋肉が微妙に動くらしい。MITのチームは被験者の顔に16個の電極を取り付け、同じ言葉を4回ずつ頭の中で発声しようとしてもらった。発声せずに脳内で発声しようとしただけなのに、16個の電極のうちの7個の電極のシグナルに変化が生じたという。

そこでまずは首から顎にそって両側から伸びるデバイスを作って、片側に7個ずつの電極をつけてデータを取得。その後改良を重ね、最新バージョンでは4個の電極がつけられた片側だけのデバイスが完成した。

そのデバイスを装着した被験者に20個の単語を「脳内発声」してもらい、そのデータを集めた。1つのタスクでは、足し算と掛け算に必要な単語。もう1つのタスクではチェスの駒の場所を「脳内発声」してもらった。

その電極データを入力データ、単語を出力データにして、ニューラルネットワークに学習させ、電極データから単語を予測するAIを作り上げた。

精度を上げるために転移学習という手法を採用。ニューラルネットワークの最初のほうの層はそのまま使い、最後の2層だけを、個々の被験者のデータで再学習させた。そうすることで、92%という高い精度の結果を得ることができたという。

骨伝導のイヤホンを使うことによって、足し算を「脳内発声」すれば、コンピューターからの答えをイヤホンで音声で聞くことができる。チェスの場合は、駒の動きを「脳内発声」すれば、コンピューターが次の打ち手を教えてくれる。チェスの相手に知られることなく、コンピューターから打ち手を教えてもらうことが可能なわけだ。

顔に装着するものだから、デザインは絶対に重要。それにまだ単語は20個しか認識できない。なので、まだまだ実用化は先の話だと思うけど、脳波以外で人間の意思を伝達する仕組みが現れたことが、興味深い。

湯川鶴章

AI新聞編集長

AI新聞編集長。米カリフォルニア州立大学サンフランシスコ校経済学部卒業。サンフランシスコの地元紙記者を経て、時事通信社米国法人に入社。シリコンバレーの黎明期から米国のハイテク産業を中心に取材を続ける。通算20年間の米国生活を終え2000年5月に帰国。時事通信編集委員を経て2010年独立。2017年12月から現職。主な著書に『人工知能、ロボット、人の心。』(2015年)、『次世代マーケティングプラットフォーム』(2007年)、『ネットは新聞を殺すのか』(2003年)などがある。趣味はヨガと瞑想。妻が美人なのが自慢。